梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

AI再一次击败人类世界冠军,登上Nature封面。

与上一次AlphaGo下围棋不同,这次不是脑力运动,而是在真实物理环境中的竞技体育项目——“空中F1”无人机竞速。

与AlphaGo也有相同之处,核心技术都是深度强化学习。

成果来自苏黎世大学,作者之一Davide Scaramuzza认为,这是国际象棋的深蓝、围棋的AlphaGo之后的又一大突破。

这标志着自主移动机器人首次在为人类设计并由人类设计的物理环境体育运动中击败人类冠军。

微软高级研究工程师Shital Shah认为这比AlphaGo更难,也更难获得认可,但仍是历史性的里程碑。

深度强化学习,又一次胜利

先介绍一下这个运动项目:FPV(第一人称视角)无人机竞速。

人类选手会通过机载摄像头传输的视频,从无人机的视角观察环境,穿越障碍。

赛道由七个方形大门组成,每一圈都必须按顺序通过。要赢得比赛,参赛者必须连续领先对手完成三圈。

两台无人机同时出发,正面对决,最高速度可达每小时100公里,同时承受数倍于重力的加速度。

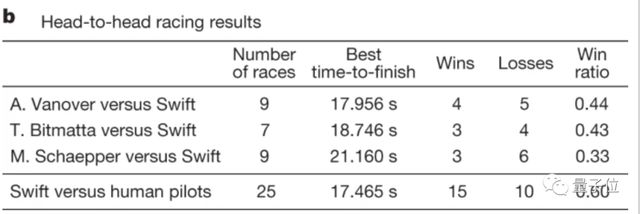

这次与AI同台的是2019年无人机竞速联盟世界冠军Alex Vanover、MultiGP国际公开赛世界杯冠军Thomas Bitmatta和三届瑞士全国冠军Marvin Schaepper。

对AI来说,要达到专业人类选手的水平非常有挑战性,因为无人机需要在物理极限下飞行,同时仅通过机载传感器估计速度和位置。

为解决这些挑战,苏黎世大学设计了Swift,由两个关键模块组成:

其中,感知系统主要是一个VIO(Visual-Inertial Odometry)模块,同时利用视觉和惯性传感器对自身定位和对环境建模。

VIO估计与神经网络相结合,用于检测障碍门的四个角点。

控制策略是一个前馈神经网络,使用无模型的On-policy深度强化学习进行模拟训练,奖励目标结合了向下一个门的中心前进,和保持下一个门在摄像机视野内。

为了弥合模拟和物理世界之间感知和动力学上的差距,使用了从物理系统中收集的数据,驱动一个MLP残差模型。

在比赛开始前,人类选手在指定赛道上有一周的练习时间,赛道包含“Split-S”等高难度机动动作。

具体规则还有:由声学信号(发令枪)开启比赛,如果发生碰撞也可以继续比赛,如果两架无人机都坠落则飞得远的获胜。

最终在与三位人类选手的比赛中,Swift分别拿下了9局5胜,7局4胜,和9局6胜的成绩。

在Swift输掉的比赛中,有40%是因为与对手发生碰撞,40%是因为与门发生碰撞,20%是因为速度比人类慢。

Swift还在比赛中取得最快记录,人类选手的最佳时间领先半秒。

在累计300圈的数据中,Swift平均时间更短,方差更低,代表AI每圈都稳定追求更快圈速。

而人类则会在自己领先时保持一个较慢的速度,降低碰撞的风险,表现出更大的方差。

这也体现出当前的Swift系统无法得知对手的情况,在领先时不够稳,落后时又不够浪。

AI与人类选手,哪里不同?

在论文中,团队还讨论了AI与人类选手的更多对比。

首先,Swift利用了机载惯性传感器,这类似于人类的前庭系统。

但反而是人类在这个项目上无法使用前庭系统,因为他们不随无人机一起移动,感受不到加速度。

另外,Swift的传感器延迟更低为40毫秒,专业人类选手平均能做到220毫秒。

但Swift的摄像头刷新率有限,只有30Hz,人类使用的摄像头则120Hz。

最后,人类有更高的韧性。

比如即使在全速坠机了只要设备没坏就能继续比赛,但Swift没有接受碰撞后恢复的训练。

如果改变比赛现场的光照环境,Swift的感知系统就会失效。

作者认为,这项研究可能会激发在其他物理系统(例如自动驾驶汽车、飞机和机器人)中跨广泛应用部署基于混合学习的解决方案。

论文地址:

https://www.nature.com/articles/s41586-023-06419-4

参考链接:

[1]https://x.com/davsca1/status/1696938013421429111